网站使用nginx来屏蔽垃圾蜘蛛访问抓取的配置文件

网站使用nginx来屏蔽垃圾蜘蛛访问抓取的配置文件

配置文件下载地址:

GitHub:https://github.com/vircloud/bots

蓝奏云:https://www.lanzous.com/i5am4cd

本站备份:点我下载

禁止垃圾蜘蛛的原因

这里垃圾蜘蛛指的大部分是采集工具的蜘蛛UA,这些垃圾工具的蜘蛛有可能是做信息收集过滤用来贩卖,有可能是直接抓取你网站内容然后发布到自己站点的蜘蛛。

屏蔽访问抓取的实现方式

利用nginx的的配置文件来实现,通过分析访问这的部分信息,来判断是否符合垃圾蜘蛛的条件从而决定是否禁止。

提醒

默认配置文件不建议大家直接用,建议根据自己站点的实际情况来进行修改。

比如这一段

#禁压缩包

location ~* \.(tgz|bak|zip|rar|tar|gz|bz2|xz|tar.gz)$ {

return 400;

break;

}这一段直接禁止了对压缩包的访问,如果你的网站有提供下载,就不能禁止他。使用时候直接将其删除或者注释掉即可。

使用教程

首先我们把配置文件下载到服务器上,存入一个不经常动的目录,可以跟nginx放一起

然后根据自己站点的情况把配置文件修改一下,保存即可

然后我们打开nginx的配置文件,在nginx的配置文件中引用我们修改过的垃圾蜘蛛配置文件

这样来引入:

server

{

......

include deny-bots.conf;

......

}然后重启我们的nginx

service nginx reload

其他

引入配置文件例子:

你如果直接在nginx引入,那么生效的就是所有使用nginx的站点

如果你单独在某个站点的配置文件中引入的话,那么生效的只是这个站点,其他nginx下的站点不受影响。

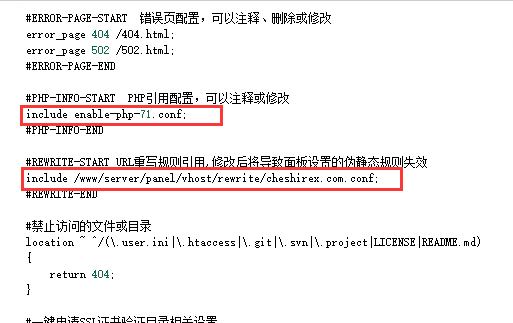

引入可以参考宝塔面板里面已有网站的配置文件来操作,下面截图中有带目录和不带目录的两种方式。

Discussion

New Comments

请问include代码写在nginx.conf文件哪里合适?一定要在server区域吗?

不是有示例了,在{}内就行